GPUとCPUで機械学習の計算スピード差がどのくらいでるか調べた結果

概要

なんだか2ちゃんねるまとめサイトのタイトルみたいになってしまいましたが^^ 個人的に気になっていた、GPUとCPU単体で機械学習のプログラムを走らせた時にどのくらいの差がでるのか簡単に調べてみました。

GPU実験機:自作ゲーミングPC(CPU intel core i7 + メモリ32GB + GPU gtx1080 )

コードはCNN(同じコードを実行。詳細割愛)

データセットはCIFAR10

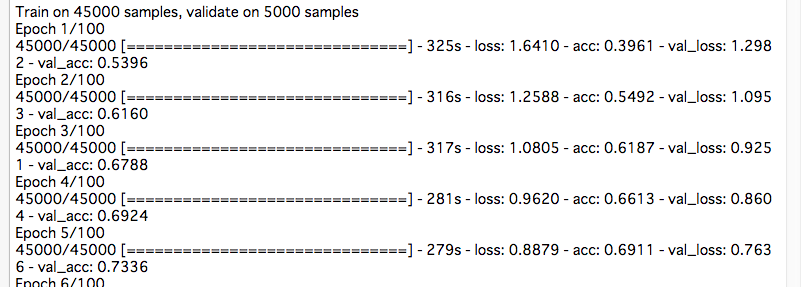

- 1エポック45000枚で学習。

結果

100エポック学習すると、実行したあと就寝して起きたらようやっと終わっていたので、8時間以上9時間以下くらいはかかっていた。

1エポック目だけ時間がかかってるけども、2エポック目からは10倍以上の性能がでた!さすがである・・・100エポックも1時間以内に終わったのであった。

おもったよりGPU温度は高温にならない。54~55度くらいを推移してる。

と、いうわけでgtx1080に投資したかいがあった模様^^